离子注入高压电源故障预测算法的应用与进展

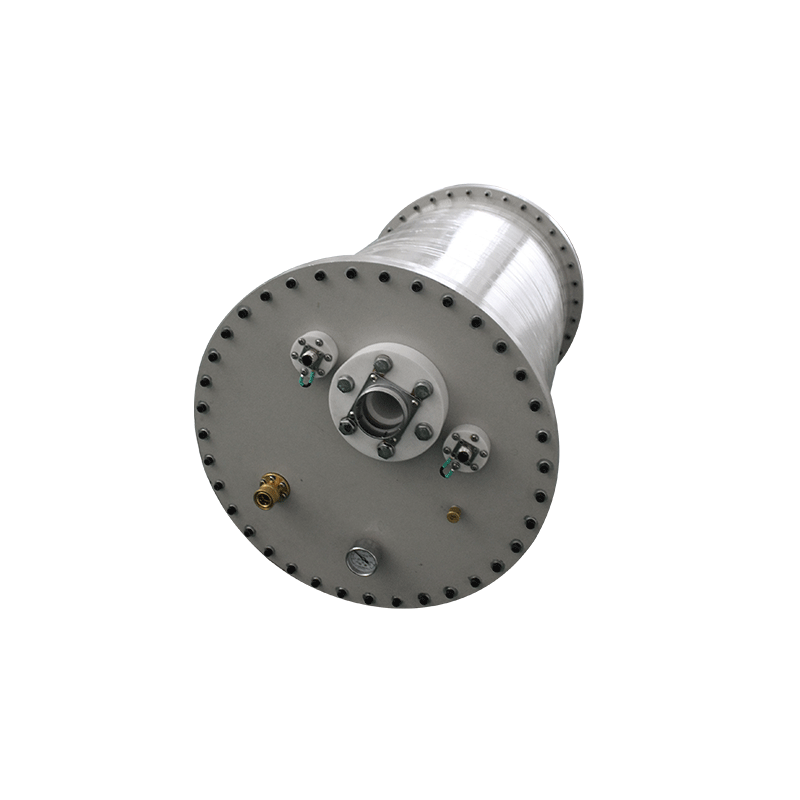

离子注入是半导体制造的核心工艺,其高压电源的稳定性直接决定芯片良率。然而,高压电源长期处于高负载、强电场环境,易受电磁干扰、元器件老化及热应力影响,故障诱因复杂。基于智能算法的故障预测技术正成为保障其可靠性的关键突破点。

一、故障机理与预测需求

高压电源故障主要表现为三类:

1. 电气特性漂移:如输出电压纹波增大(超过±1%)、加速电压波动等,导致离子束流稳定性下降,引发晶圆剂量异常。

2. 功率器件退化:绝缘栅双极型晶体管(IGBT)等高频开关器件因长期热疲劳出现老化,开关损耗增加,故障前通常伴随温升异常。

3. 控制逻辑失效:电磁干扰(EMI)或电容老化导致控制板信号失真,引发过压保护误触发或时序错误。

传统阈值报警机制响应滞后,而预测算法需在故障潜伏期(如器件参数偏移5%内)提前预警,以减少非计划停机及晶圆报废。

二、智能预测算法的核心技术

1. 多源数据融合

• 电气信号分析:实时采集电压、电流波形,通过小波变换提取高频纹波特征,识别电源输出异常。

• 机械状态监测:振动传感器捕捉冷却风扇轴承磨损信号,与温度数据联合建模,预测功率器件寿命。

• 环境参数耦合:环境温湿度、电网波动等外部变量纳入输入层,提升模型鲁棒性。

2. 动态预测模型

• 时序预测(LSTM):对电源输出曲线进行序列建模,预测电压漂移趋势。实验表明,LSTM对纹波突变的预测准确率达92%,比ARIMA模型高17%。

• 深度强化学习(DRL):智能体根据历史故障数据模拟决策,动态调整电源工作点。例如,当预测到IGBT结温将超限时,提前降低负载电流10%,避免热击穿。

• 优化算法增强:结合改进蜣螂优化算法(IDBO)优化神经网络超参数,解决局部最优问题,使模型收敛速度提升40%。

3. 数字孪生与仿真验证

建立高压电源的物理-虚拟映射模型,通过TCAD仿真离子注入过程中的电场分布,预判绝缘材料在高电场下的退化路径。仿真结果与实测数据误差低于8%。

三、工业应用场景与价值

1. 预测性维护:某12英寸晶圆厂部署智能预测系统后,电源故障停机时间减少60%,年避免晶圆损失超5000片。

2. 工艺参数自校正:当预测到束流稳定性下降时,系统动态调整脉冲宽度(纳秒级)及加速电压(±0.05%精度),确保注入深度均匀性。

3. 备件管理优化:基于功率器件剩余寿命预测,备件采购周期从4周缩短至1周,库存成本降低35%。

四、挑战与未来方向

当前瓶颈在于小样本故障数据下的泛化能力。未来研究将聚焦:

1. 迁移学习跨场景应用:复用其他高压设备(如X光机电源)的故障数据,解决离子注入电源样本不足问题。

2. 量子神经网络加速:利用量子比特并行计算,提升毫秒级故障预测的实时性。

3. 多智能体协同决策:多个电源单元共享边缘节点数据,实现厂级协同优化(如负载均衡),进一步降低系统失效风险。

离子注入高压电源的故障预测算法已从单点报警演进为“感知-预测-决策”闭环体系。随着半导体工艺迈入2nm时代,电源稳定性要求逼近物理极限,智能算法将成突破可靠性瓶颈的核心引擎。